I. ProblĂŠmatique▲

Faire connaÎtre son site Web n'est plus suffisant. Il faut aujourd'hui se focaliser sur chaque thème abordÊ par un site, chacune des pages ayant son propre contexte.

Le rĂŠfĂŠrencement est une bataille de tous les instants dans laquelle ceux qui font attention aux moindres dĂŠtails prennent de l'avance sur ceux qui laissent leur site vivre sa vie et sur ceux qui, au contraire, s'en occupent de trop.

Il ne s'agit pas de simplement remplir les balises META de chaque page HTML. Il s'agit de techniques bien plus avancĂŠes, plus subtiles, qui sont mĂŞme parfois hors de notre contrĂ´le.

I-A. PrĂŠsentation▲

Ă l'origine, il y avait des sites. Ils restaient isolĂŠs et n'ĂŠtaient pas prĂŠvus pour le grand public.

Ensuite, les besoins de notoriĂŠtĂŠ se sont fait sentir. C'est ainsi que sont arrivĂŠs les annuaires et les moteurs de recherche.

Il me semble fondamental de situer le contexte avant de rentrer dans le vif du sujet.

I-B. Historique▲

Avant 1993, il Êtait difficile de trouver du contenu. Le concept de  spider  n'existait pas (du moins, pas en tant que programme automatisÊ permettant de construire des index aussi complets que ceux qui existent aujourd'hui). Chacun conservait une liste de ses sites favoris et l'Êchangeait avec les autres internautes. Ce comportement n'a d'ailleurs pas totalement disparu.

Grâce à ce système basÊ sur la confiance, chacun pouvait se reposer en ce qu'un site affirmait contenir au moyen de la fameuse balise META.

En 1995 sont apparus deux majeurs du rÊfÊrencement que nous connaissons encore aujourd'hui : Yahoo! (Yet Another Hierarchical Officious Oracle,  encore un oracle officieux et hiÊrarchique ) et AltaVista ( vue de haut , dont les crÊateurs travaillent maintenant pour Google). Yahoo! organisait les sites selon des thÊmatiques hiÊrarchisÊes, tandis qu'AltaVista prÊfÊrait prendre une approche de recherche.

à cette Êpoque, le rÊfÊrencement Êtait fondÊ sur les informations que chaque webmestre pouvait renseigner dans ses propres pages (balise META). Le propriÊtaire avait donc un contrôle total, permettant de donner des indications arbitraires. C'est un hÊritage de l'ère prÊcÊdente. Les webmestres commencèrent ainsi à donner de fausses informations de manière à attirer davantage de visiteurs.

Google est arrivÊ en 1998 avec une nouvelle mÊthode de rÊfÊrencement : le PageRank, fondÊ principalement sur les backlinks. L'idÊe Êtait de trouver un moyen qui permette de dÊterminer la popularitÊ d'une page Web et qui soit le critère principal pour classer les rÊsultats d'une recherche.

Le rÊsultat est explosif, le succès fulgurant. Aujourd'hui, Google est incontestablement le moteur de recherche le plus utilisÊ, mais dont les prÊdÊcesseurs ne se laissent pas abattre.

En 2001, Google atteint une popularitÊ sans prÊcÊdent, juste après que les moteurs de recherche abandonnent les balises META comme critères (cet abandon a lieu au dÊbut du siècle).

En 2004 sont lancÊs les deux concurrents majeurs actuels de Google Search : Yahoo! Search et MSN Search (Microsoft).

I-C. Comprendre les moteurs de recherche▲

Le rÊfÊrencement est constituÊ de trois Êtapes :

- Web crawling ( parcours du Web ) ;

- Indexing ( mise à l'index du contenu ) ;

- Searching ( recherche ).

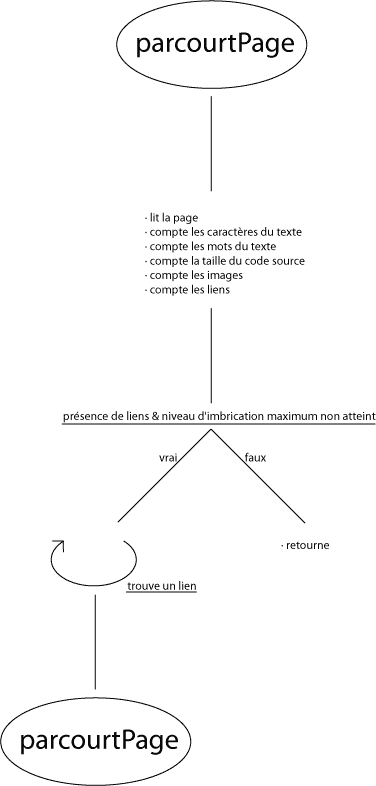

Je vous propose, afin de parfaitement comprendre comment fonctionne un spider (la première Êtape), de faire le nôtre. N'ayons pas peur, ce n'est pas très complexe.

Notre robot se contentera de lire une page Web et d'en donner la liste des images, du contenu et des liens ; il suivra quelques-uns de ces liens afin de nous donner des statistiques sur les pages liĂŠes, et ce sur quelques niveaux. Un vĂŠritable spider devra aller bien plus loin (reproduire cette opĂŠration Ă l'infini), mais nous ne disposons pas d'une puissance de calcul phĂŠnomĂŠnaleâŚ

TĂŠlĂŠcharger le script (ĂŠcrit en PHP)Â : [ ./fichiers/spider.zip ] ou [ https://g-rossolini.developpez.com/tutoriels/seo/fichiers/spider.zip ]

Je ne mets pas ce script en dÊmonstration, car il est très gourmand en bande passante.

Cet exemple a plusieurs objectifs : d'une part, vous dÊmontrer que le spider ne peut pas analyser autre chose que du texte (adieu les images et les animations en Flash) ; d'autre part, vous sensibiliser aux ÊlÊments qui ont de l'importance dans une page (attributs  alt  des images et  title  des liens, par exemple : je les ai mis en gras quand ils sont disponibles).

L'Êtape de mise à l'index comprend une analyse complète du contenu, des liens, du code, etc. C'est ici que l'algorithme entre en jeu et que la plus grosse partie des calculs sont effectuÊs.

La recherche est une Êtape relativement simple : il s'agit simplement de trouver (dans l'index) les pages qui correspondent aux termes recherchÊs, puis de les classer.

I-D. Les techniques▲

Chapeau blanc (ÂŤÂ white hat )▲

Ce sont les mĂŠthodes honnĂŞtes.

Il s'agit des mĂŠthodes de SEO permettant simplement de suivre les conseils des moteurs de recherche. Cela vise simplement Ă construire des sites au contenu utile et correctement mis en valeur.

Exemples :

- SÊlectionner les mots clefs avec grand soin ;

- Ne pas trop diversifier les thèmes traitÊs par un même site Web ;

- Utiliser du code HTML correct ;

- etc.

Je ne souhaite pas donner davantage de dĂŠtails ici puisque cela fera l'objet de divers tutoriels sĂŠparĂŠs.

Chapeau noir (ÂŤÂ black hat )▲

Ce sont les mÊthodes manipulatrices de rÊsultats. Je vous les dÊconseille, car elles ne sont pas pÊrennes ; de plus, elles sont Êthiquement incorrectes.

Il s'agit des mĂŠthodes permettant de manipuler les rĂŠsultats de moteurs de recherche en utilisant des failles dans les algorithmes des moteurs. Ces techniques peuvent fonctionner, mais les moteurs de recherche les combattent activement, ce qui laisse penser qu'elles deviennent inefficaces (voire pĂŠnalisantes) avec le temps.

En fÊvrier 2006, Google supprimait de son index les sites de BMW Allemagne et de Ricoh Allemagne pour avoir utilisÊ ces techniques. Les sites en question ont Êvidemment remÊdiÊ à la situation dans des dÊlais très brefs.

Exemples :

- Spamdexing : parvenir à tromper l'algorithme du moteur de recherche pour que le site reçoive davantage d'audience qu'il le mÊrite ;

- Cloaking : fournir au moteur de recherche une version diffÊrente du site par rapport à ce que voient les visiteurs ;

- Link farms : construire un rÊseau de sites qui s'Êchangent des liens, de manière à augmenter leur quantitÊ de backlinks ;

- etc.

Je ne souhaite pas donner davantage de dÊtails ici puisque je n'adhère pas à ces techniques.

I-E. Principes gĂŠnĂŠraux▲

Pour optimiser ses pages Web, il suffit d'ĂŞtre le plus honnĂŞte possible.

Voici quelques ÊlÊments :

- construisez des pages au contenu consÊquent : ayez du volume sans pour autant faire dans la longueur ;

- organisez votre contenu : structure du site, arborescence ;

- rÊdigez correctement : orthographe, grammaire, etc. ;

- mettez en forme : titre, gras, italique, etc. ;

- pensez Ă mettre une balise <h1></h1> dans chaque page, Ă renseigner la balise <title></title>âŚ

Vous remarquez le point central : le contenu. Tout s'applique Ă mettre en valeur le contenu de votre page. Pourquoi ? Simplement parce que c'est ce que le visiteur cherche dans le moteur de recherche. Il veut une rĂŠponse Ă une question, donc du contenu. C'est Ă cela qu'il faut penser quand vous optimisez : sĂŠlectionnez les mots clefs que le visiteur devra pouvoir trouver dans vos pages et brodez Ă partir de cela. Vos liens doivent contenir un texte d'ancrage faisant rĂŠfĂŠrence Ă ces mots ou Ă des synonymes ; les mots eux-mĂŞmes doivent ĂŞtre situĂŠs Ă des endroits stratĂŠgiques (titres, en dĂŠbut de page, mis en forme, etc.)âŚ